저자:

서원덕, 신태섭, 안현진, 김도균, 이승현

소속:

Enhans AI, AI Research

게재:

IEEE IEEE International Conference on Big Data (BigData) 2025 Industry Track

핵심요약

- 본 논문은 Q2K(Question-to-Knowledge)를 소개하는데, 이는 SKU 매칭을 불투명한 유사도 판단이나 단일 LLM 응답에 의존하는 대신, 검증 가능한 사실(inspectable facts)을 생성하고 검증하는 과정으로 전환하는 멀티 에이전트 LLM 프레임워크다.

- Q2K는 Reasoning, Knowledge, Deduplication 세 에이전트와 최종 Decision 단계로 구성되며, GPT-4o, OpenAI 웹 검색 API, text-embedding-3-small 기반의 추론 이력 검색을 결합해 작동한다.

- QA 감독을 통해 구축된 7만 2천 개 이상의 상품쌍(대부분 F&B) 데이터셋에서 Q2K는 95.62% 정확도를 기록하며, 규칙 기반, zero-shot, few-shot, 웹 검색 기반 접근보다 우수한 성능을 보였고, 추론 재사용으로 불필요한 웹 호출을 감소시켰다.

- Enhans AI의 상용 파이프라인에서 Q2K는 가격 모니터링, 소싱 최적화, 번들 탐지와 같은 고정밀 SKU 매핑을 지원하며, 전통적 규칙 기반 시스템이나 즉흥적 LLM 프롬프트보다 감사·유지 관리가 쉬운 투명하고 재사용 가능한 추론 체인(Reasoning Chain)을 제공한다.

초록 (Abstract)

두 제품 리스트가 동일한 SKU(Stock Keeping Unit)를 가리키는지 식별하는 작업은 전자상거래에서 지속적인 도전 과제이며, 특히 명시적 식별자가 누락되어 있고 상품명이 플랫폼마다 크게 다를 때 더욱 어렵다. 규칙 기반 휴리스틱과 키워드 유사도 방식은 브랜드, 사양, 번들 구성과 같은 미세한 차이를 간과해 제품을 잘못 분류하곤 한다. 이러한 한계를 해결하기 위해 본 연구는 신뢰도 높은 SKU 매핑을 위해 대규모 언어 모델(LLM)을 활용하는 멀티 에이전트 프레임워크 Q2K(Question-to-Knowledge)를 제안한다. Q2K는 (1) 목표 지향적 비모호화 질문을 생성하는 Reasoning Agent, (2) 집중된 웹 검색을 통해 이를 해결하는 Knowledge Agent, (3) 중복을 줄이고 일관성을 확보하기 위해 검증된 추론 이력을 재사용하는 Deduplication Agent를 통합한다. human-in-the-loop 절차는 불확실한 사례를 추가로 개선한다. 실제 소비재 데이터셋 실험 결과, Q2K는 강력한 베이스라인을 상회하는 정확도와 강건성을 보였으며, 특히 번들 식별과 브랜드·원산지 비모호화와 같은 어려운 시나리오에서 두드러졌다. 또한 반복적인 웹 검색 대신 재수집된 추론을 재사용함으로써 정확도와 효율성을 균형 있게 달성해, 확장 가능하며 해석 가능한 제품 통합 솔루션을 제공한다.

서론 (Introduction)

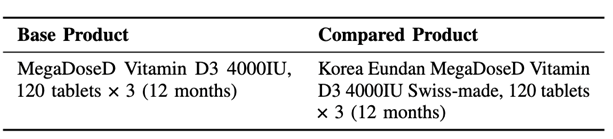

본 논문은 전자상거래의 실질적 난점에서 출발한다. 제품 제목은 복잡하고 식별자(예: 바코드)가 종종 누락되며, “Swiss-made”, “family pack”, 변형명, 프로모션 문구와 같은 미세한 표현 차이가 동등성 판단을 뒤바꿔 단순 문자열 매칭을 불신뢰하게 만든다. 규칙 기반 파이프라인은 카테고리 간 유지보수가 어렵고, 유사도 모델은 세밀한 속성 논리를 반영하지 못하며, 대규모 도메인 특화 모델을 재학습하는 방식은 비용이 높고 카탈로그 변화에 따라 빠르게 구식이 된다. 새로운 모델을 파인튜닝하는 대신, 본 연구는 일반 목적 LLM과 실시간 웹 검색, 그리고 재사용 가능한 추론 메모리를 결합해 강건한 SKU 매핑 시스템을 구축할 수 있는지 탐색한다. Q2K는 그 답이다. 이는 LLM을 단순한 정답 제공자가 아니라 (1) 모호한 요소를 식별하고, (2) 외부 근거를 수집하며, (3) 적절할 때 과거 추론을 재사용하는 통제 가능한 추론 엔진으로 다루는 멀티 에이전트 파이프라인이다. 이러한 전환은 SKU 매핑을 단발성 분류 문제가 아닌 투명한, 검색 기반 추론 과정으로 변화시킨다.

데이터셋 및 방법 (Datasets and Methods)

데이터셋

본 데이터셋은 전문 판매자들이 참여한 반수동 방식으로 구축되었다.

- 각 base_product에 대해, 라벨러는 지정된 이커머스 사이트를 검색하고 candidate compared_product 제목을 수집한다.

- 그 후 어떤 후보가 동일 제품인지, 비동등 제품인지 명시적으로 라벨링한다.

- 상급 검토자가 노이즈 라벨을 교정한다.

최소한의 전처리 후 각 인스턴스는 다음과 같이 저장된다:

(base_product, compared_product, y)

여기서 y ∈ {0, 1}은 SKU 동등성을 의미한다. 최종 데이터셋은 약 72,250개 상품쌍으로 구성되며, 대부분 F&B 도메인이다. 수작업 체크 결과 약 3–5%의 라벨 노이즈가 존재하며, 이는 원산지 강조 또는 미묘한 번들 차이와 같은 경계 사례에서 발생한다. 이는 정제된 벤치마크보다 실제 상업 환경을 반영한다.

모델 구성

- 모든 Q2K 에이전트는 GPT-4o(temperature = 0)를 API로 호출해 결정적이고 재현 가능한 출력을 생성한다.

- Knowledge Agent는 OpenAI 웹 검색 API를 사용해 최신 제품 정보를 조회한다.

- 추론 이력 저장소는 text-embedding-3-small을 사용해 임베딩되며, 질문 및 질문 집합을 벡터 공간에 매핑한다.

- 코사인 유사도를 기반으로, 새로 생성된 질문 시퀀스가 저장된 항목과 얼마나 가까운지 계산하고, Top-5 검색 연산자 R5(⋅)는 재사용 후보 추론을 반환한다.

평가 방법

태스크: SKU 동등성 이진 분류

지표: Accuracy (ŷ는 예측 레이블)

비교 기준 모델 (Baselines)

모델의 성능이 아닌, 추론 전략을 비교하기 위해 모든 베이스라인은 GPT-4o 기반에서 구현되었다.

- Rule-Based Matching: 결정적 문자열 정규화, 브랜드 사전, 수량·사양 매칭

- Zero-Shot Inference: 예시 없이 LLM에 “같은 제품인가?”를 직접 질의

- Few-Shot Inference: 소량의 라벨 예시 후 새로운 쌍을 분류

- Web-Search Inference: 두 제품의 웹 스니펫을 프롬프트에 추가한 뒤 구조화 없이 판단

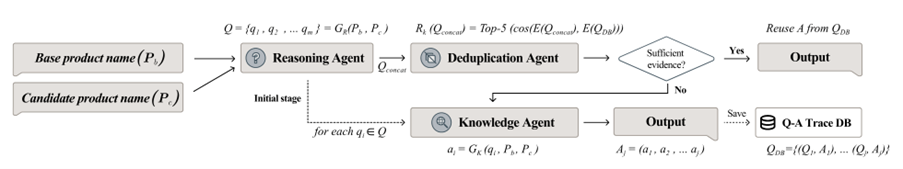

프레임워크 상세 (Question-to-Knowledge (Q2K))

Q2K의 핵심 아이디어는 다음과 같다: “Ask → Gather → Reuse → Decide.”

이는 세 개의 에이전트와 하나의 최종 결정 단계로 구현된다.

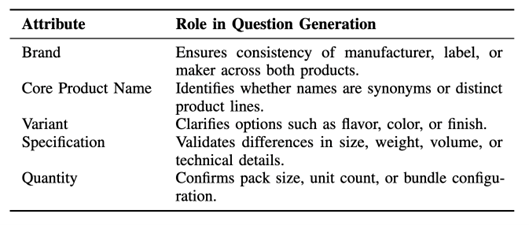

1. Reasoning Agent – Ask Better Questions

- 입력: (Pb, Pc), 즉 base와 candidate 제품명

- 출력: SKU 동등성에 중요한 속성에 초점을 둔 비모호화 질문 집합 Q = {q1,…,qm}

질문은 다음 5개 매칭 차원에 의해 안내된다:

에이전트는 거대한 체크리스트가 아니라 필요한 만큼의 최소 질문만 생성하도록 설계되어 있어, 분해가 목표 지향적이고 효율적이다.

2. Knowledge Agent – Gather Inspectable Facts

- 각 질문 qi에 대해, 웹을 조회하고 ai = Gk(qi, Pb, Pc) 형식의 간결한 답변을 생성

- 출력은 SKU 비교를 위해 맞춤형으로 구성된 짧고 독립적인 근거 문장

- 답변은 A = {a1,…,am}으로 정리되며, 결과적으로 해당 제품쌍에 대한 소규모 “factsheet”가 된다

3. Deduplication Agent – Reuse Reasoning When Possible

- 반복적 추론을 피하기 위해 Q2K는 다음과 같은 지식 저장소를 유지한다:

- QDB = {(Q1, A1), …, (Qj, Aj)}

여기서 Qj는 질문 시퀀스, Aj는 검증된 답변이다.

- 새로운 쌍에 대해 Q2K는 현재 질문을 하나의 Qconcat으로 이어붙이고 임베딩한 뒤 Top-5 유사 추론 R5(Qconcat)을 검색한다.

- Deduplication Agent는 기존 추론이 새로운 사례 판단에 충분한 정보를 제공하는지 판단한다.

- 충분하면 → 저장된 답변을 재사용하고 웹 검색을 생략

- 부족하면 → 새 Knowledge Agent 호출 후 새로운 reasoning을 저장소에 추가

4. Decision Stage – Make the Final Call

최종 에이전트는 다음 입력을 활용한다:

- Pb, Pc

- 생성된 질문 Q

- 재사용 또는 새로 생성된 답변 A

이 정보들을 5개 차원에서의 일관성을 기반으로 검토하고 다음을 출력한다:

- 이진 레이블(1 동일 SKU, 0 상이 SKU)

- 짧고 사람이 읽을 수 있는 설명

이 구조는 모든 결정을 추적 가능하게 만든다. 어떤 질문이 생성되었고, 어떤 방식으로 답변되었으며, 어떤 과거 reasoning이 재사용되었는지 확인할 수 있다.

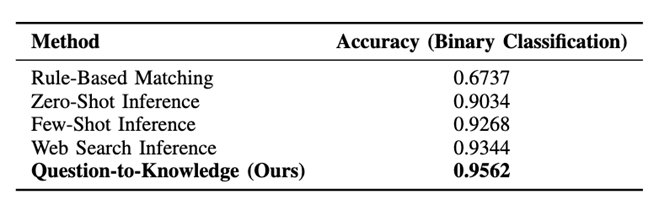

실험 결과 (Experimental Results)

주요 실험 결과 (Main Experiment Result)

- 규칙 기반 방식은 약 67.4%로 낮은 성능을 보이며, 이름 변형, 프로모션, 세부 사양·수량 차이에서 쉽게 실패한다.

- Zero-shot GPT-4o는 의미적 이해를 활용해 약 90.3%까지 도달하나, 사실 정보가 부족한 경우 오류가 발생한다.

- Few-shot은 92.7%로 개선되지만, 예시 범위의 한계를 벗어나기 어렵다.

- 웹 검색 기반 추론은 실시간 정보 덕에 93.4%로 가장 강력한 베이스라인이지만, 구조화되지 않은 검색 결과로 인해 중복과 불일치가 생긴다.

- Q2K는 95.62%에 도달하여 모든 베이스라인을 초과하고, 유사 제품군 간 reasoning 재사용을 통해 효율성까지 개선한다.

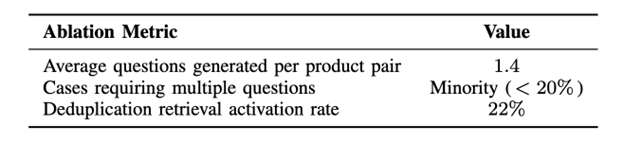

절제 실험 및 동작 분석 (Ablation and Behavior Analysis)

- Reasoning Agent는 평균 1.4개의 질문만 생성하며, 20% 미만의 사례만 복수 질문이 필요해 집중적이고 효율적이다.

- Deduplication Agent는 약 22%의 비교에서 기존 reasoning을 재사용하며, 이는 전체의 약 1/5이 새로운 웹 호출 없이 해결됨을 의미한다.

- 이는 비용과 지연을 감소시킬 뿐 아니라, 유사 제품군을 동일한 근거와 논리로 평가할 수 있어 일관성을 높인다.

종합적으로, 구조화된 검색 기반 멀티 에이전트 추론(Q2K)은 비구조적 LLM+웹 검색 방식보다 정확성과 효율에서 모두 우수한 결과를 보인다.

결론 (Conclusion)

Q2K는 SKU 매핑을 위한 단순하지만 강력한 파이프라인을 구현한다:

모호성 분해 → 검증 가능한 사실 수집 → 기존 reasoning 재사용 → 투명한 결정.

이는 제품 매핑을 단순 문자열 유사도 또는 불투명한 LLM 분류 문제로 취급하는 대신, 세 에이전트와 확장되는 reasoning 이력을 중심으로 한 question-to-knowledge 과정으로 전환한다. 본 프레임워크는 다음을 제공한다:

- 기존 규칙 기반 및 LLM 베이스라인보다 높은 정확도(95.62%)

- 명확한 질문과 근거를 기반으로 한 해석 가능성

- 추론 재사용을 통한 확장성 및 비용 효율성

Enhans AI에서는 이를 통해 더 신뢰도 높은 제품 정규화, 가격·구색 분석, 다양한 클라이언트·도메인 간 재사용 가능한 추론 자산을 확보할 수 있다.

in solving your problems with Enhans!

We'll contact you shortly!